La singularidad es una religión

Leo por ahí que la idea de la singularidad, que incluye la predicción de que la evolución de la (mal llamada) inteligencia artificial superará y hará obsoletas las capacidades de la inteligencia humana, es una religión.

Leo por ahí que la idea de la singularidad, que incluye la predicción de que la evolución de la (mal llamada) inteligencia artificial superará y hará obsoletas las capacidades de la inteligencia humana, es una religión.

O sea, en último término, la consecuencia de un acto de fe: el de la capacidad de quienes la defienden de crear una tecnología que supere las facultades que hasta ahora considerábamos exclusivas de los humanos.

O, si se prefiere, una consecuencia del cientificismo, la ideología que sostiene que la ciencia es el único modo válido de entender el mundo y resolver problemas sociales.

Me parece razonable. De hecho, la confianza ilimitada de muchos en el poder de la ciencia y de la tecnología es también una creencia basada en un acto de fe. O, si se prefiere, no pasa de ser una hipótesis de trabajo. Puede parecer plausible, porque la ciencia y el método científico han generado respuestas a muchos retos teóricos y prácticos. Pero no es demostrable que sean aplicables a todos los retos presentes y futuros.

«Los seres humanos siembre han construido mitos colectivos, con el objetivo de cohesionar, controlar y dar un sentido a su experiencia compartida. Los mitos nos guían, nos inspiran y nos permiten vivir en un universo que en último término es incontrolable y misterioso. Pero también pueden cegarnos ante las necesidades reales urgentes. […] La religión de la tecnología es uno de esos mitos.»

(David Noble, «La religión de la tecnología«).

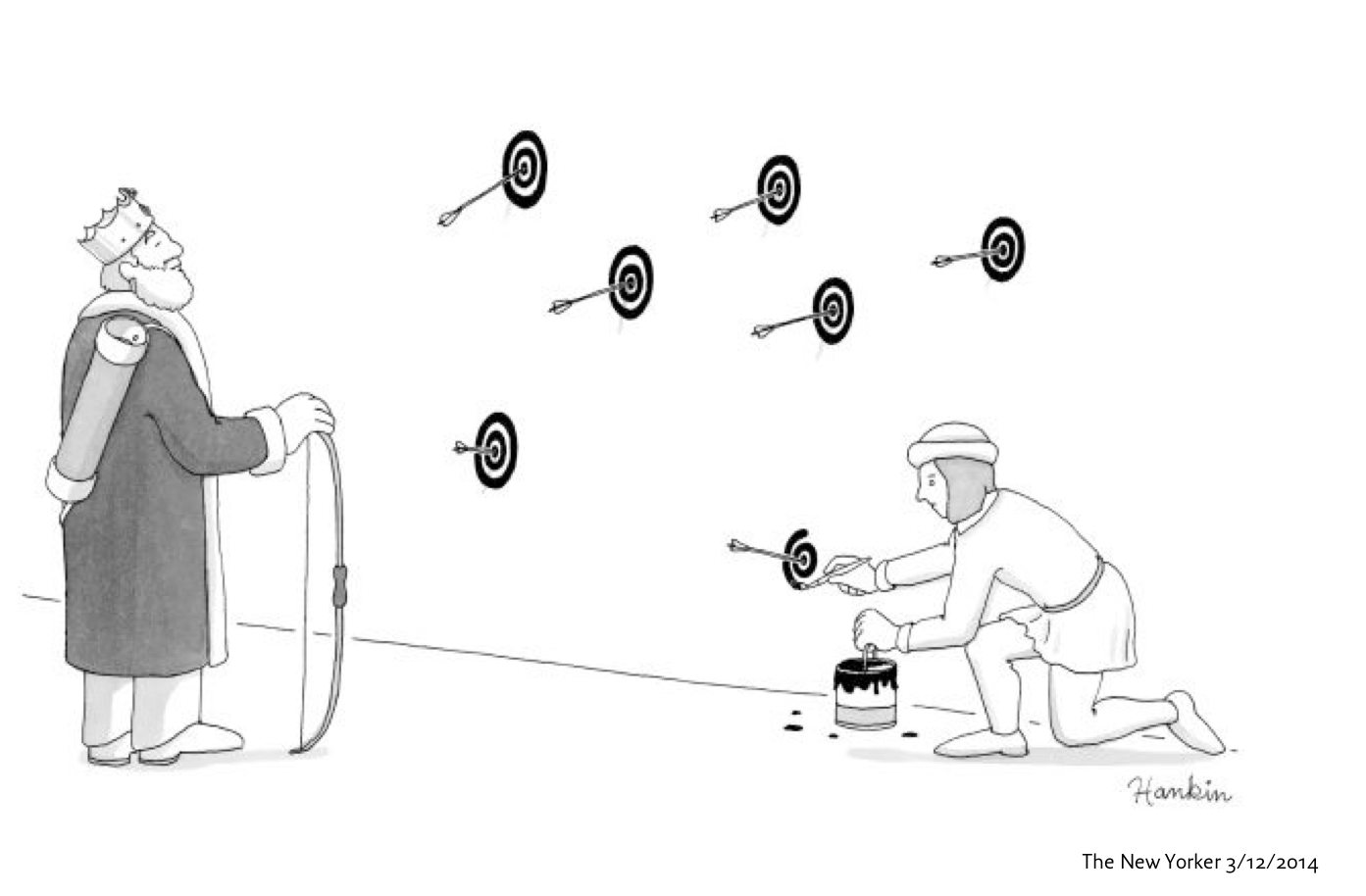

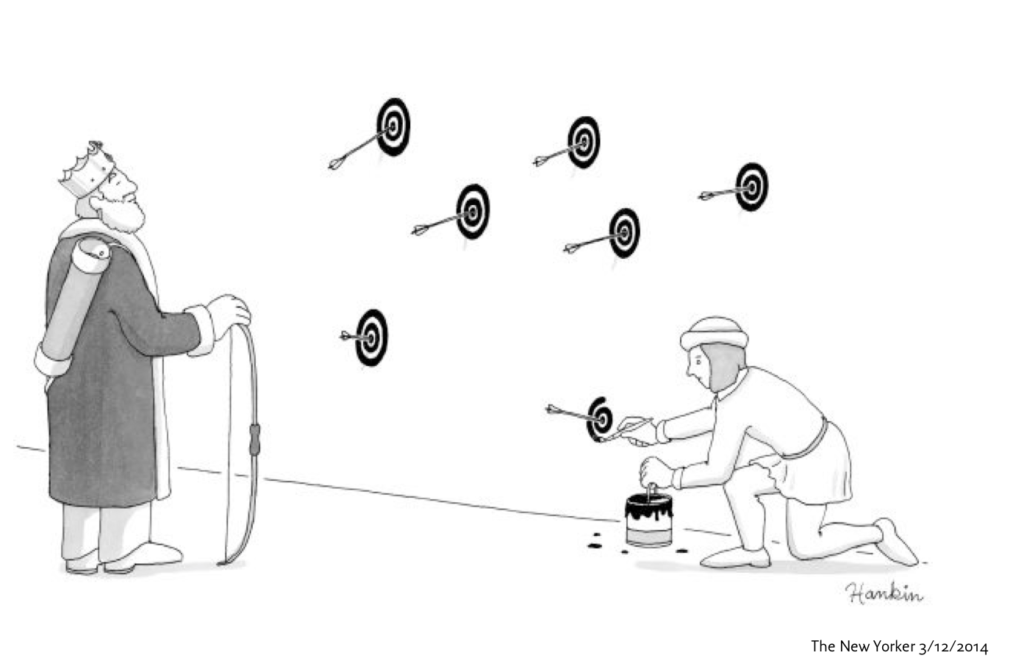

Desde siempre hay quienes han instrumentalizado las religiones como instrumentos de poder sobre la conciencia y los comportamientos de personas y sociedades. Lo cual obliga a preguntarse si la religión de la singularidad se basa en un acto de buena fe, o es simplemente un instrumento interesado para acumular riqueza y poder. Más aún cuando quienes con mayor entusiasmo defienden la idea de la singularidad (p.e. la Singularity University) son los mismos que promocionan empresas exponenciales cuyo éxito, por la misma idea de exponencialidad, es alcanzar posiciones de oligopilio en sus mercados.

Conclusión. No perdamos la fe en la ciencia, pero desconfiemos de los ‘ultras de la ciencia’. Uno de ellos escribía hace poco en El País que «la ciencia siempre acaba destruyendo las creencias«. Una afirmación muy radical que sin embargo no deja de ser una creencia sin base científica.

Para acabar. En ocasión de su 150 aniversario, la prestigiosa revista científica Nature ha publicado algunas reflexiones muy interesantes sobre el presente y futuro de la ciencia. Las recomiendo (y tal vez las comente en el futuro).

- «We ignore the past at our peril»

- «Can marketplace science be trusted?«

- «Science must move with the times«

- «Discovery is always political«